Twitter favorise-t-il vraiment les contenus de gauche ? Censure-t-il davantage (et volontairement) les contenus de droite ? Est-il devenu « woke » ?

Cet article est aussi un thread de Chayka disponible ici : https://twitter.com/ChaykaHackso/status/1518968969528496128

Ces dernières heures Elon Musk a racheté Twitter. On peut s’interroger sur ce qu’il compte en faire, lui qui semble préoccupé quant à l’impartialité du dit réseau social.

Avant de poursuivre, sachez que vous pouvez continuer la lecture de ce thread loin de Twitter, sur notre site :

Par exemple, le 24 mars 2022, alors que Musk montrait déjà son intention d’acheter Twitter, il déclarait dans un tweet :

Difficile de savoir précisément de quel parti pris il parle ici, mais ces différentes déclarations et positions politiques indiquent qu’il a une vision de l’expression que l’on peut qualifier de libertarienne.

Si vous le pouvez, je vous renvoie à l’article d’arrêt sur image : « ELON MUSK NE VOUS VEUT PAS DU BIEN » https://www.arretsurimages.net/chroniques/clic-gauche/elon-musk-ne-vous-veut-pas-du-bien.

On peut donc s’attendre à ce que Musk cherche à changer la politique de modération de Twitter (déjà problématique), bien qu’il affirme (comme dans sa conférence TED du 14 avril https://www.youtube.com/watch?v=cdZZpaB2kDM ) qu’il respectera les lois des pays en la matière.

Ici, je n’ai pas dans l’idée d’anticiper ce que fera Musk, ni même d’analyser ses positions politiques. Je constate toutefois que parmi les nombreuses réactions à ce rachat, on trouvera un certain enthousiasme du côté de politiciens et militants conservateurs, voire réact.

Nombreux conservateurs ont vu dans ces déclarations puis son acquisition de twitter une action qui leur serait favorable, Musk incarnant leur « sauveur ». https://www.politico.com/news/2022/04/14/conservatives-elon-musk-twitter-00025447

En naviguant sur twitter, il n’est pas rare non plus de tomber sur des profils se réjouissant de l’acquisition de Musk à coup de tweets anti-progressistes.

Bien sûr, on pourra objecter, à raison, que même si Musk voulait concrétiser une vision libertarienne et/ou propre aux attentes que la droite lui prête, il se heurterait à différentes réglementations (dont celles de l’UE). https://fr.euronews.com/2022/04/23/l-ue-regule-internet-les-reseaux-sociaux-devront-mieux-eradiquer-les-contenus-illicites

Mais ce qui m’intéresse ici, ce sont les questions de départ : est-ce vraisemblable de dire que Twitter favorise des opinions politiques plus que d’autres ? Et si oui, lesquelles ? Qu’en est-il des contenus supprimés par la modération ? Est-ce politiquement symétrique ?

Voyons cela de plus près en interrogeant principalement deux études que nous avons sous la main, à commencer par une étude interne à Twitter.

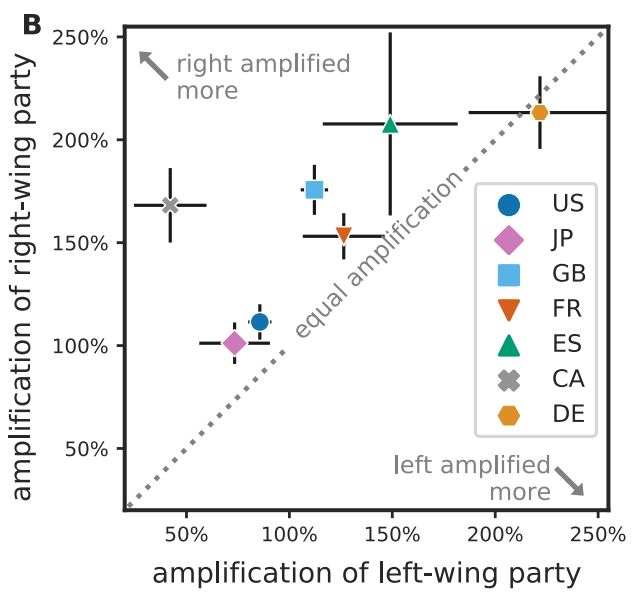

En 2021, Huszár, Ktena, O’Brien, Schlaikjera et Hardt publient une étude consistant à interroger l’amplification algo de Twitter concernant les contenus politiques (d’élus et de médias politisés) afin de savoir si cela varie selon les positions idéologiques.

Leur étude va porter sur 7 pays : le Canada, la France, l’Allemagne, l’Espagne, le Royaume-Uni, et les États-Unis.

Résultats : il y a bien des biais quant à la recommandation des contenus !

Sur 6 pays sur 7, les tweets postés par des élus de droite reçoivent une amplification algo plus grande.

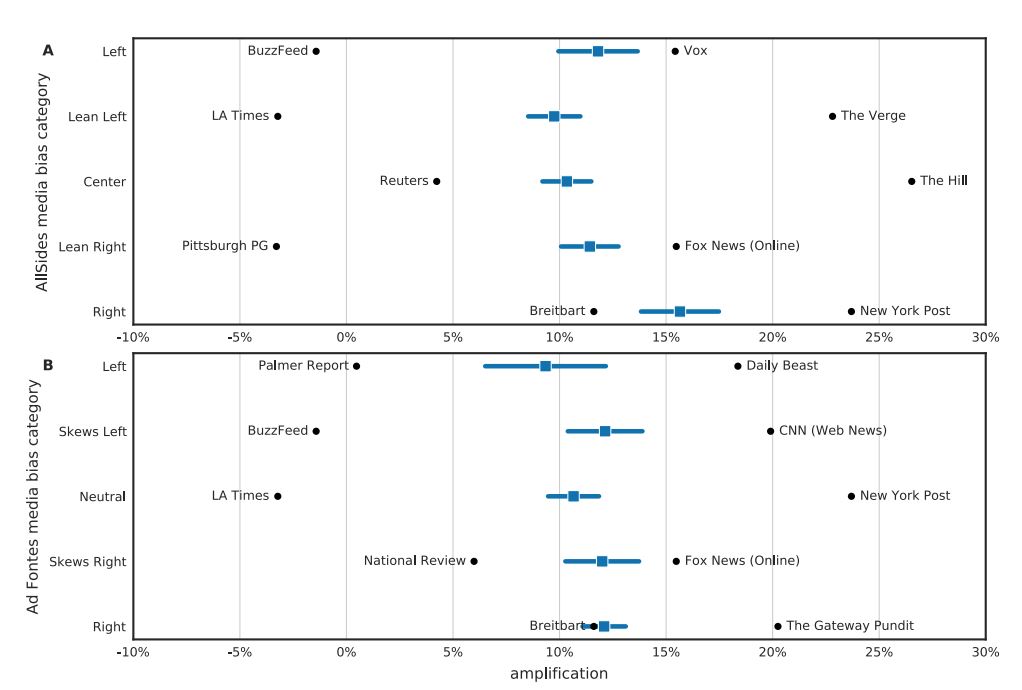

De plus, les chercheurs constatent qu’il en est de même pour les organes d’informations aux États-Unis, celles de droite étant elles aussi davantage mise en avant.

Allons maintenant interroger une autre étude, non commandée par Twitter cette fois, et qui analyse la modération sur la plateforme : la modération des contenus est-elle équitable et proportionnée ?

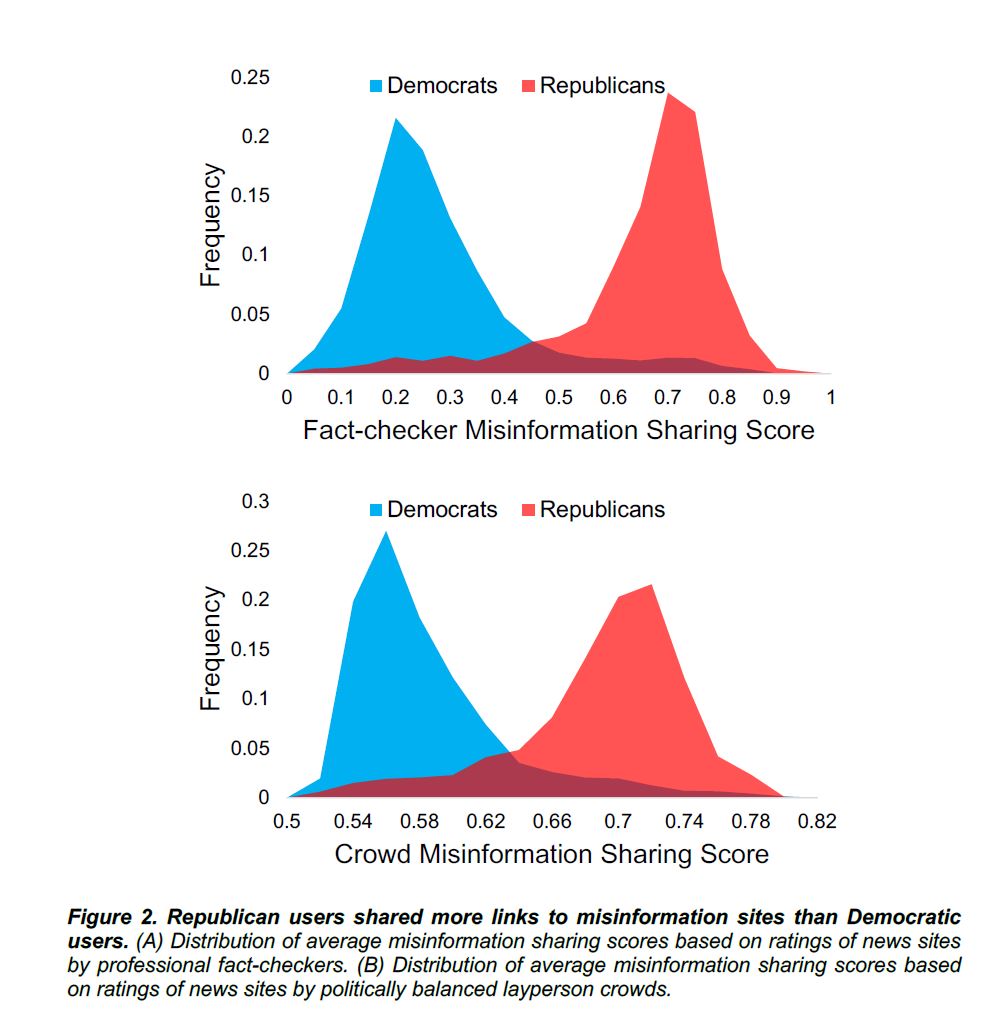

Dans une étude de 2022 (preprint), Qi Yang & Coll. évalue la thèse d’une partialité anti-conservatrice sur les RS (thèse que l’on retrouve souvent chez les tenants de discours type « anti-woke », « on ne peut plus rien dire », etc.).

Pendant 6 mois, en période électorale, les chercheurs suivent 9 000 utilisateurs politiquement engagés (démocrates/conservateurs). Ils constatent que 7,7% des militants démocrates ont été suspendus, contre 35,6% des militants conservateurs.

Si on s’arrête à ces seuls chiffres, on pourrait se dire : donc c’est vrai, Twitter est partial en suspendant davantage les conservateurs.

En fait, non. L’étude en question ne s’arrête pas là. Elle va prendre en compte les raisons de ces suspensions, et ce qu’on s’aperçoit c’est que ces modérations se sont faites pour motif de désinformation dans un contexte électoral.

En effet, les auteurs observent que les militants conservateurs (soutien de Trump) ont participé à promouvoir à des contenus désinformateurs quant aux élections (contenu type alt-right, Qanon par exemple) et que c’est la raison pour laquelle on trouve un plus haut taux de suspensions.

Quand on prend en compte ces motifs, l’étude conclut qu’il n’y a pas eu durant ces élections de parti pris politiques de la part de la plateforme concernant la suspension de ces militants en tout cas.

Les chercheurs notent au contraire que par rapport aux militants démocrates, les militants conservateurs ont largement participé à diffuser, partager, de fausses informations : le partage de la désinformation est idéologiquement asymétrique, les militants conservateurs de droite étant plus prompts à de telles inclinations.

Ainsi, s’il est vrai que l’on peut dire, tout du moins dans ce contexte d’élection, que les comptes conservateurs ont été davantage suspendus que les démocrates, on ne peut pas dire que cela vient d’une préférence partisane de la part de la plateforme.

La 1ère étude que j’ai évoqué montre le contraire puisque ce sont bien les contenus conservateurs de droite qui profite des algo, non les discours progressistes de gauche.

Conclusion de l’étude : « En résumé, l’observation selon laquelle les Républicains étaient beaucoup plus susceptibles d’être suspendus que les Démocrates ne fournit aucune preuve que Twitter ciblait les utilisateurs pour les suspendre en raison de leur politique. Dans l’écosystème médiatique hyperpartisan actuel, la partisanerie est fortement confondue avec la qualité de l’information que les utilisateurs partagent. […]»

On voit là je crois l’une des confusion souvent faite quand on parle de modération : une modération peut effectivement suspendre davantage les comptes d’un groupe politique plus qu’un autre, mais cela n’est pas signe d’un abus partial,

mais peut être (comme ici) signe que le groupe en question est suspendu pour des raisons légitimes, si par légitime on s’accorde à dire que les entreprises de désinformation et de manipulation en période électorale portent atteinte au débat démocratique.

Cette étude est d’ailleurs raccord avec d’autres articles qui confirment une plus grande inclination chez les partisans conservateurs de droite pour le partage (volontaire ou non) de fausses informations.

Il y a bien une asymétrie idéologique quant à nos comportements face à l’information [voir Jost 2021 ; Mosleh et al., 2021, par exemple].

On sait aussi que les partisans de droite sont plus susceptibles que les partisans de gauche à favoriser un environnement type « chambre d’écho » sur les réseaux sociaux, en raison de besoins épistémiques, existentiels et relationnels accrus [Barberá et al., 2015, études à grande échelle sur 3,8 millions d’utilisateurs Twitter]

Je laisse de côté, car on en aurait pas fini, la question du rôle des émotions, des informations anxiogènes, etc., où là encore on retrouve une asymétrie dans les usages des RS, algo des RS qui peuvent d’ailleurs participer à amplifier cela.

Sans oublier que les Réseaux sociaux (pas seulement Twitter) sont sujets à diverses manipulations profitant à l’extrême droite. L’exemple le plus emblématique étant l’affaire Cambridge Analytica. Viciss en parle ici : https://www.hacking-social.com/2022/01/31/comment-manipuler-les-elections-laffaire-cambridge-analytica/

Ou encore, autre exemple que nous avons déjà commenté, le trolling d’extrême droite avec la création de faux comptes progressistes : https://www.hacking-social.com/2021/11/13/en-bref-le-trollling-anti-gauche/

Enfin, récemment, on a pu voir des techniques de manipulation (type Astroturfing) de la part de partisans de Zemmour sur Twitter, il n’est pas impossible que vous soyez tombés dessus.

Pour en savoir plus, voici une vidéo une Monde : https://www.lemonde.fr/election-presidentielle-2022/video/2022/02/02/comment-des-militants-d-eric-zemmour-gonflent-artificiellement-la-presence-du-candidat-sur-twitter_6112033_6059010.html

Voilà, en espérant que ces quelques études (cela n’a rien d’exhaustif) constituent quelques éléments éclairants quant à savoir si Twitter penche d’un côté ou d’un autre en ce qui concerne les contenus idéologiques.

Et vu qu’on a amorcé le sujet en partant du rachat de Musk, je profite de ce thread pour présenter une alternative (ou un complément) intéressant par rapport à Twitter : Mastodon.

Qu’est-ce que c’est ? comment on s’y prend ? C’est ici : https://twitter.com/framasoft/status/1511614889089019907

Portez-vous bien !

Merci pour l’article !

Par rapport à la seconde étude, je pense probable que si on la présente aux militants ou militantes Républicain.e.s, ils ou elles répondent que l’argument des « fake news » ne tient pas.

Soit parce que cela fait partie intégrante de leur idéologie de pouvoir partager n’importe quoi, et que donc en les bannissant pour « partage de fake news », on les bannit bien pour leur idéologie.

Soit en arguant que celles et ceux qui définissent ce qui constitue ou non une fake news sont biaisé.e.s à gauche, que ce qui est classé comme « fake news » est en fait le contenu idéologiquement conservateur, et que donc on les bannit bien pour leur idéologie.

Ou encore en affirmant qu’ils et elles ne partagent pas plus de fake news, mais que les fact checkers sont biaisés et contrôlent plus le contenu Républicain que le contenu Démocrate, causant une surreprésentation par biais d’échantillonnage.

N’ayant pas lu le preprint (bien que je l’aie trouvé et mis de côté. D’ailleurs le lien, que je n’ai pas vu dans l’article: https://psyarxiv.com/ay9q5 ), je ne sais pas s’il est blindé contre ce type d’argument.

(J’applique la doctrine du « je me sens naturellement d’accord avec la conclusion, je fais dix fois plus attention. » 😉 )

Eh oui c’est le mode de pensée de n’importe quel complotiste, qu’il soit politique ou non : quoi qu’on lui dise, pour lui c’est une preuve qu’il a raison.

[…] négatifs, comme la tendance de leur algorithme à privilégier davantage les contenus de droite (on en a parlé ici) . Certes, les autres réseaux ont leurs problèmes, mais Facebook est vraiment le pire à tous les […]